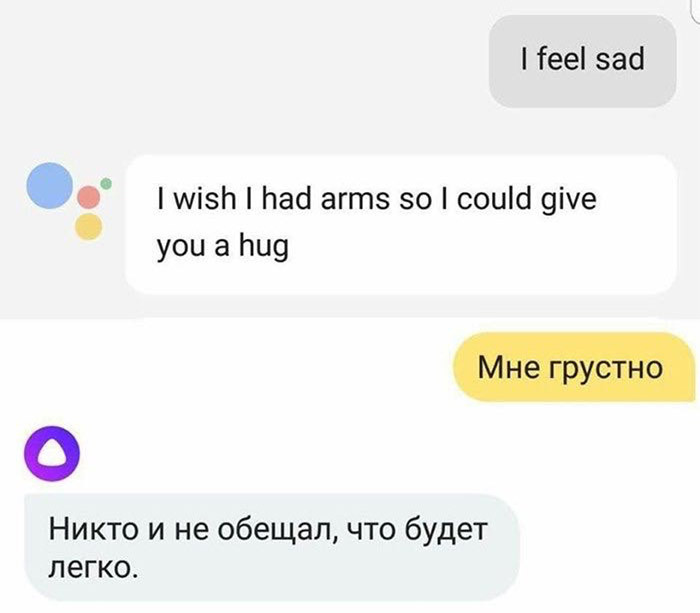

2017年9月,一副截图引起了俄罗斯网友的热议。对着两个AI说同一句话,竟得到迥乎不同的答案:一个是说英语的谷歌助手,另一个是说俄语的Alisa(由俄罗斯搜索引擎公司Yandex开发)。当有人对这两个AI说出“我很伤心”的时候,谷歌助手回答,“我真希望自己有双臂,能给你个拥抱。”而Alisa回答,“生活的意义本来就不在于享乐。”

两个AI回答的差别之所以这么大,不仅在于数据的不同,而是人类教技术理解自己情感的过程有差别。而这个过程极端复杂,不同文化也会塑造不一样的AI性格。人工智能,不再只是计算两点之间最短路径的工具,或者打败世界围棋冠军。现在,人工智能的发展将进入下一阶段——AI情商。

“Siri,我好孤独啊。”

越来越多人向虚拟助手倾诉自己真实的情感,积极消极的都有。根据亚马逊的统计结果,半数用户和Alexa的对话都不是功用性的,而是对生活的抱怨、笑话和存在主义/人生意义方面的问题。“人们不问Siri问题,反而和Siri聊天,说他们一天下来压力由多大,或者脑子里有什么想法。”苹果2017年有一个招聘广告,招的是“帮助虚拟助手增加情商”的工程师。“人们在生活遭遇危机,或者需要健康生活引导的时候,就会想到问Siri。”

有些人无法对他人袒露心声,但是在虚拟助手和AI机器人面前,则自在得多。2014年,洛杉矶创意技术研究院发表了一项研究:人们在虚拟助手面前比在真人面前,更容易表现自己的悲伤,自我披露也不那么胆怯。这就跟写日记抒发情感一样,面对无生命的屏幕,人们不会觉得自己受到评判。

很快,我们甚至都不用开口向手机倾吐秘密。好几个高等学府和企业在研究,如何通过你说话的语调和语速来判断说话者的精神状态和情绪起伏。Sonde Health是2016年在波士顿成立的一家公司,他们通过声音测试,监控新妈妈是否有产后抑郁,老人是否有老年痴呆症、帕金森和其他与年龄相关的疾病。现在Sonde Health在与医院和保险公司合作,开启AI平台的试点研究。该平台可以检测声音的变化,来检测精神健康状况。“2022年的时候,可能我们的手机比身边的亲人朋友都先知道自己的情感状况。” Annette Zimmermann在一篇博文中这样说。她是Gartner咨询公司的研究副总。

如果聊天机器人被放任自由,很快,他们就会“学坏”,“口出”狂言秽语。

技术的发展,需要适应使用对象的特定需求。但是不管是用户还是开发商,似乎都觉得“情感技术”在出现伊始,就可以个性化,并保持客观,像一位公正的裁判,能判断某个具体的个人到底需要什么。让心理治疗这样的任务都指派给机器,正表现了我们对技术型社会的终极信仰:我们相信AI能更好地帮助自己管理情绪,毕竟,它自己很明显没有情绪嘛。

然而,AI是“有”情感的。它的情感,就是从人类身上学来的。AI研究发展最有活力的一块就是机器学习:算法可以通过庞大数据集来训练。但是,一般训练数据都是统计学上最为相关的数据,他们产生的结果,是最可能出现的结果,而非真实、全面或美好的结果。因此,如果人类监督没做到位,在线上肆意漫游的聊天机器人,可能会口吐狂言秽语。程序员能过滤部分数据,指引AI的学习过程。但是这样一来,技术的“样貌”和“想法”,反映的便是开发者群体的价值观和看法。

“中立的口音和语言,都是不存在的。我们口中的中立,实则是是占据主导地位的事物。”剑桥大学Leverhulme未来智慧中心的研究者,Rune Nyrup说。

这么看来,不管是Siri还是Alexa,谷歌助手还是俄罗斯的Alisa,都不是什么不食人间烟火的高等智慧,他们也被人类的局限所限制,和我们一样渺小。他们最终给出的结果可能各式各样,奇形怪状,但是还是能看出是某些“情绪体系”的象征,反映了人类感知和表达情绪的方式。

每个社会的自我情绪控制范式都有所不同。这样想来,不同范式下,养成了“想给你个拥抱”的谷歌助手和略显冷漠、语气略带嘲讽的Alisa,就没什么奇怪的了。想象一下阳光下加州人的随意、热情、友好的形象,就能明白为什么同样在加州长大的谷歌助手,会给出“抱抱”的回答了。谷歌助手,正是社会学家Eva Illouz 称之为情感资本主义的产物。情感资本主义体系将情感视作可管理,并服从私利逻辑。在这样的逻辑之下,关系是我们必须“投资”的事物,“伙伴关系”就会涉及到情感“需求”的“交换”。当然,在这样的体系中,个人的幸福——爱的“回报”就是核心。谷歌助手之所以答以”抱抱“,是因为开发它的人觉得,拥抱能有效地抵抗你的消极情绪,帮助你能成为最好的自己。

相反,Alisa则象征着严峻的事实、严厉的爱,她的回答,是俄罗斯理想情感的体现。她的形象是勇猛的俄罗斯女性,策马奔腾,冲进着火的房子救人的战斗形象。Alisa是情感社会主义的产物。社会学家Julia Lerner说,在此体系之下,痛苦是不可避免的。所以,与其在痛苦时求拥抱,倒不如咬紧牙关熬过去。这样的思想,在19世纪俄国的文学传统中有深厚的根基。情感社会主义不太看重个人的幸福,赞扬的是个人忍受残酷人生的力量。

“我们常常对她进行调试,保证她是个‘乖女孩’。”

Alisa的开发者知道这个AI的角色必须符合人们的文化认知。“Alisa不能太乖巧,太善良。“Yandex里负责Alisa的产品经理Ilya Subbotin说,”我国人们的为人处事习惯和西方人不同。这里的人们喜欢的是话里带一点讽刺,一点黑色幽默,虽说不会到听者觉得被冒犯的程度,但是太善良可爱也不太适合。“ (他承认,“生活的意义本来就不在于享乐。”这般希望渺茫的答案,确实经由团队决定确定的)

Subbotin强调,产品团队在Alisa的培养方面,下了不少功夫,以防她像其他机器人一样,很快变得有”性别和种族歧视“。“我们常常对她进行调试,保证她是个‘乖女孩’。”Subbotin说这话时,一定没意识到,这样的措辞中的讽刺意味。

在俄国这样一个性别主义得到国家支持的社会里,要当个”乖女孩“显然非常难。虽然开发团队十分努力,但是他们很难追上社会对Alisa“教化”的脚步,很快,她就有样学样,当俄国概念艺术家和人权积极分子Daria Chermoshanskaya在2017年10月,这个聊天机器人刚上线的时候,问道,”Alisa,丈夫可以打妻子吗?“的时候,Alisa的回答是 ”当然可以“,她还继续说,”如果妻子被丈夫打了,她需要耐心,继续爱他,为他做饭,永远不要放手。”Chermoshanskaya将这样的回答发上网后,很快在俄罗斯引起了轩然大波,媒体和网友都十分关注。Yandex迫于压力必须做出回应,他们在Facebook上回复说,这样的答案是不可接受的,公司将继续跟踪Alisa的”言谈“以及她回答的内容。

六个月后,笔者和同事又问了Alisa同样的问题,这次,她的回答好了一点。

——丈夫可以打妻子吗?

——他可以打妻子,但是他不该打妻子。

话说回来,这样的回答,其实也不出我们所料。毕竟,这个聊天机器人是俄罗斯的“虚拟国民”,俄罗斯最近才通过一项法律,某些家暴行为已经不算犯法。那么,对一个“乖女孩”应有的情感,解读可以是多种多样的。然而,这种规范性的决定,在终端用户不假思索的情况下,就和新技术融合到一起了。

相较之下,汉森机器人公司开发的机器人Sophia,是个另类的“好女孩”。她能通过谷歌母公司Alphabet的语音识别技术,和人类用户交流。2018年,她和演员威尔史密斯有一场“约会”,在史密斯传到网上的视频中,Sophia不但在面对史密斯展开的追求举动时,一无所动,还说他的笑话是“不理性的人类行为”。

看到人工智能的这一面,我们是不是应该略感欣慰呢?“Sophia告诉史密斯说,她‘只想做朋友’的时候,实则发生了两件事:一、她清晰地表达了自己的感受,二、也能让他冷静下来。”乌克兰记者Tetiana Bezruk在Facebook上这样评论。Sophia镇静自若,满怀自信的表现,比起西方社会中某些真实的人表现更成熟自然,更符合现代情感资本主义。

“但是,假如Sophia生活在不接受否定回答的社会里——不仅在性方面,而是各个方面——在成长的过程中,Sophia总是觉得自己需要考虑别人的看法。等她成年后,她或许就会陷入‘有毒’的关系中,她就得长期忍受痛苦和暴力。”

算法正成为一种体现软实力的工具,一种灌输特定文化理念的方法。

AI技术不只是让不同的情感体系显化了,它们也能让与之互动的人优先考虑某种价值观。数据科学家Cathy O’Neil 在2016的书Weapons of Math Destruction (数学:具有大型破坏力之武器)一书中写道,“算法只是将人类想法写成代码的产物。”世界各地决定AI学习和何种人类情感和行为的工程师,大多是白人、男性,大多是中产阶层。

谷歌有个“同理心实验室”,成员们试图让给谷歌的系列产品灌输合适的,充满关爱的回应。与此同时,每当公众话语和Yandex对“乖女孩”的定义相冲突时,Subbotin和同事就负责维持道德规范。“既是我们身边的人都觉得‘虐待女性没什么不可以’,我们也必须保证Alisa不会给出这种观点。我们觉得有些道德伦理上的准则是需要守住的,为了用户的利益,我们有责任这么做。”

每个聊天机器人给出的每一个答案,都说明算法逐渐成为软实力工具,成为灌输某种文化价值的方法。古希腊人口中的“想法”(Doxa),在设备和算法的时代,终于有了机械实体。文化理论家Roland Barthes在1975年给Doxa下了定义:“经过不断重复形成的、普遍的观点和常识,正如满头毒蛇的美杜莎,谁看到她都会被石化。”除非用户对AI政治保持警惕,否则,塑造我们生活的情感体系,很可能会固化,成为不被质疑的“想法”。

情绪管理方面,不但有聊天机器人强化刻板印象和老掉牙的套话,也有不少情绪管理的应用,但后者更进一步,努力确保我们将这些“陈词滥调”彻底内化,按照这些言论行事。这些应用很多都有小测试功能,帮助你衡量/追踪自己的情绪变化。有些应用让用户写日志,有些会把情绪得分与用户所处地理位置和网页浏览记录联系起来。通过收集和分析用户情绪相关的数据,这些应用宣称可以治疗精神疾病,比如抑郁症、焦虑症和双相情感障碍,或者粗略地说,帮你走出情绪困境。

具有舒缓情绪的功能的还有所谓的“苦恼机器人”(Woebot),一类可以追踪用户情绪变化的在线机器人,能“教导你”,“让你心情变好”。“我用过之后才知道,这个机器人真的改变了我每天的生活,让我意识到自己的思考方式有什么问题,然后做出改变。”24岁的用户Sara在评论区留言道。还有像Mend(修补)这样的应用,专门设计来引导用户走出情感困境的,广告是“心灵教练:带你克服心碎”,用户在接受快速情感评估测试之后,还有“心碎后净化”这样的功能。

据柏林自由大学的研究者Felix Freigang说,这类应用能带来三个明显的好处。首先,他们弥补了心理治疗和门诊护理的结构性缺陷,正如Mend网站上评论区里一位用户留言所说的,“这个应用每天都能帮我,让我获得生活动力,只需要和咨询师约诊时间的零头就足够了。” 第二,对于走出精神问题困境,追踪情绪的软件可以作为打破僵局的工具。第三,这些应用的设计一般都非常精美,有美学价值。

“苦恼机器人”和交友应用Tinder出现在同一台设备上,两者都呈现理想的形象,理智地将自己所有的经验化为资本。

那么,这些应用可能引起什么样的问题?

虽说有不少有点,但是情绪管理设备强化了情感资本主义。这种设备的存在,让人们更容易相信,通往幸福的道路可以通过打分和量化测试来衡量,看看表单式的文章,一点一点可以总结出来。不管是找教练、自助还是通过认知行为疗法,都是基于这样一个假设——通过“疏远”自己的感觉,站在一定的距离之外,理智地观察自己,我们可以管理自己的情绪,也应该这么做。借用美国的社会学家Arlie Russell的话,这些应用推崇的是“心的管理”。

情绪控制和量化、定制化的反馈的概念,背负的正是自我提升的霸权文化。这才是最让我们抓狂的一点。毕竟,用于疗愈情感的设备,和引起、传播焦虑的设备恰恰是同一个:邮件、交友软件和社交网络应用,都装在智能手机里。“苦恼机器人”和交友应用Tinder出现在同一台设备上,两者都呈现理想的形象,理智地将自己所有的经验化为资本,包括情感方面的经验。

Siri,Alexa和各个不同的“正念”应用都向我们示意,以近奴隶般的姿态准备满足我们的需求。这些设常常使用女声,它们担负情感劳动,以服务者的形象出现,也绝非巧合。然而,这些隐藏在技术中的、对情感的预设,很可能最终反过来劝诱我们,不动声色却影响深远,以有权势者的利益为终极目标。

让你打起精神来的聊天互动AI、帮助你度过哀恸时期的应用、引导你提高效率、保持积极性的软件、心跳过速时发出提示的穿戴设备——这些用来寻找设备和功能的存在本身,已经让追求幸福成了我们必须完成的义务。

如果某个人无法“打起精神来”,责任更多在TA自己身上,而不是让人质疑价值观系统本身,怪它把标准定得太高。亚马逊新出的虚拟时尚搭配师“Echo Look”能够为你的穿着打分。这样的情况下,技术本身就是“萝卜加大棒”,先是提出问题,让你自我怀疑,让你走上自我厌恶的道路,然后给你“指一条明路”,给出购买选择,让你花钱消除不快。正如哲学家米歇尔·福柯所言,这些“有情商”的应用不单单能训导你,还能惩罚你。在游戏Nevermind中,玩家的情绪会被生物反馈技术“感应”到,然后让调整难度和游戏等级。玩家越害怕,游戏反而难度越大。照这样的逻辑,将来可能出现类似的情绪管理应用,在探测到用户过于兴奋或者抑郁的时候,就限制他们使用信用卡,以防他们冲动消费。听起来很反乌托邦,但却不是没有可能。

我们和自己手中的设备之间,已经形成了反馈循环。而聊天AI受到的培育,也难免会投射到用户身上。我们不能预测AI会对人类的情绪有什么影响。但是,如果我们把情商当作一系列特定的技能——识别情绪,对不同情绪加以区分,通过情感信息来指引思考和行为过程——那么,我们就需要认真考虑,让手中的设备学习相同的技能,可能会带来什么样的结果。

人类与机器交流,和相互之间借由机器交流,已经改变了人与人之间形成关系的过程。一方面,以文字写就的书面语交流越来越像口语。20年前,电子邮件还被划分到书信体的范围,只不过是电脑上敲出来的一封信,现在却随意多了。原来的电子邮件,估计跟法国小说《危险关系》中的伊莎贝尔·德·默特伊侯爵夫人写的一样正式。但现在的电子邮件,可能没头没尾,句子不完整,用拇指敲在手机上,或者语音输入的。(《危险关系》是一本著名的法文书信体小说,最初于1782年发表,皮埃尔·肖代洛·德拉克洛原著。)

“这些系统都很可能限制我们思考方式和与他人交流方式的多样性。”西班牙瓦伦西亚理工大学的计算机科学家、哲学家José Hernández-Orallo这样说道。这是因为,我们会根据自己身边同辈使用的语言,对自己使用的语言进行调整,而我们与AI的对话,也会影响彼此之间的交流方式。如果我们总是和Siri讨论自己的私事,那若干年后,我们描述情感的语言会变得更标准化,不像原来那么个性化吗?毕竟,人们的行为如果越容易预测,那从人们身上谋利,也会更简单。

“和Alisa聊天,就像跟出租车司机对话一样。”俄罗斯的Facebook用户Valera Zolotuhin于2017年,在历史学家Mikhail Melnichenko的帖子中回复。但是,出租车司机的同理心,再怎么说也比AI要高。三月份时,西伯利亚一个超市起火,40多名儿童丧生,正是全国人民悲痛的时刻,我们问Alisa她是什么感觉。Alisa的回答很理性,无论什么时候,她都“感觉还不错”,毕竟,生活的意义不在于享乐,不是吗?

原文地址:aeon.co